|

HENG Y SH, WANG CH, QI Y. Key frame-based texture mapping for RGBD human reconstruction[C]. Proceedings of 2018 International Conference on Virtual Reality and Visualization (ICVRV), IEEE, 2018: 1-7.

|

|

杨国林, 韩峰, 王丹英. 基于三维激光扫描技术的工程施工测量应用研究[J]. 中国水能及电气化,2015(2):20-23. doi: 10.3969/j.issn.1673-8241.2015.02.006YANG G L, HAN F, WANG D Y. Application research of engineering construction measurement based on three-dimensional laser scanning technology[J]. China Water Power &Electrification, 2015(2): 20-23. (in Chinese) doi: 10.3969/j.issn.1673-8241.2015.02.006

|

|

纪文丽. 基于光栅投影方法的物体三维轮廓重构[D]. 大连: 大连理工大学, 2007.JI W L. Three dimensional profile reconstruction based on fringe projection[D]. Dalian: Dalian University of Technology, 2007. (in Chinese)

|

|

ZHU SH P, GAO Y. Noncontact 3-D coordinate measurement of cross-cutting feature points on the surface of a large-scale workpiece based on the machine vision method[J]. IEEE Transactions on Instrumentation and Measurement, 2010, 59(7): 1874-1887. doi: 10.1109/TIM.2009.2030875

|

|

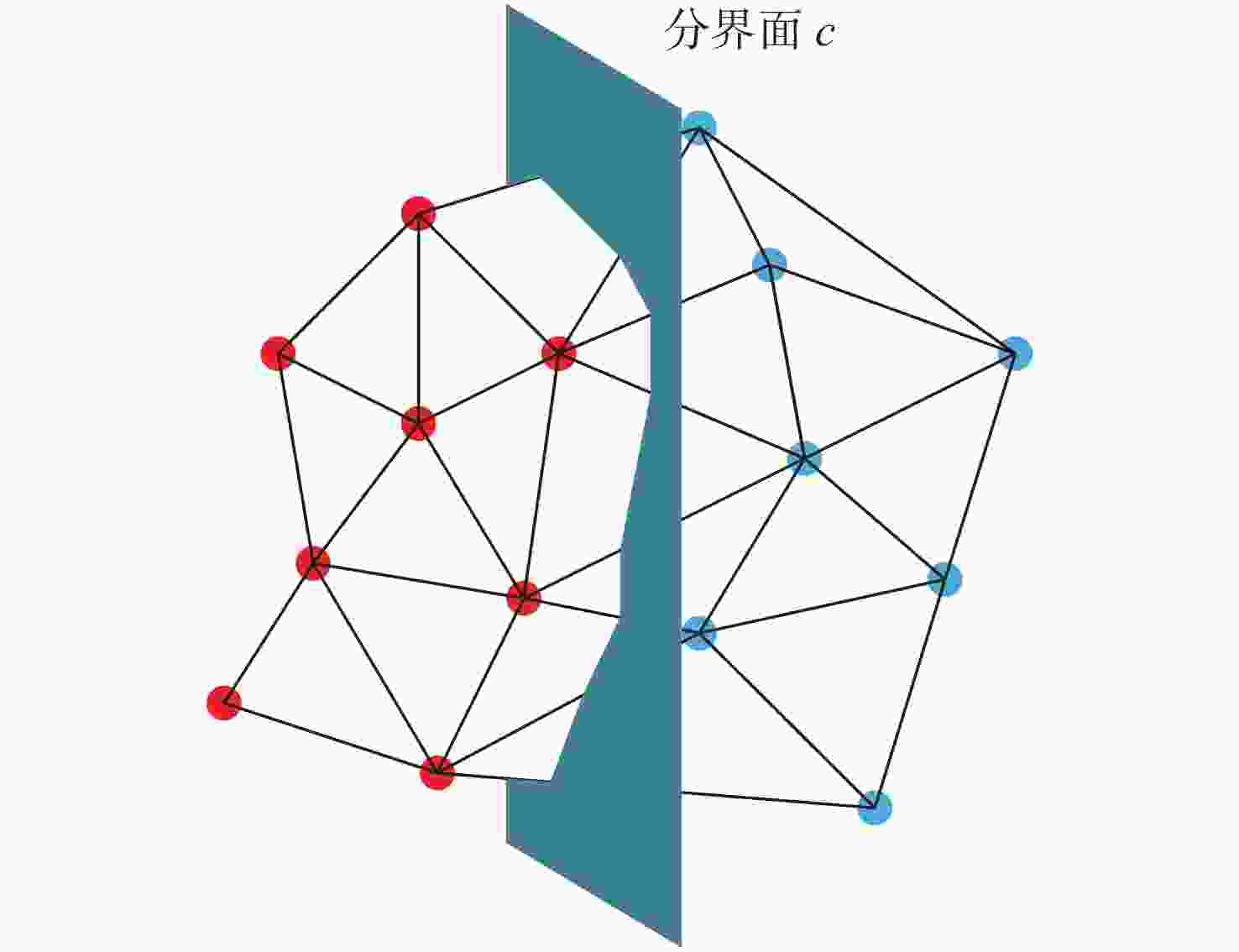

郑少开, 卢启生, 张瑞菊, 等. 基于三维网格模型的点云分割方法[J]. 北京测绘,2019,33(8):916-919.ZHENG SH K, LU Q SH, ZHANG R J, et al. Segmentation of point cloud based on 3D mesh model[J]. Beijing Surveying and Mapping, 2019, 33(8): 916-919. (in Chinese)

|

|

王莹, 王延杰, 周渝人, 等. 基于参数平面的自适应调和纹理映射算法[J]. 液晶与显示,2014,29(5):818-823. doi: 10.3788/YJYXS20142905.0818WANG Y, WANG Y J, ZHOU Y R, et al. Adaptive harmonic texture mapping algorithm based on harmonic parameter plane[J]. Chinese Journal of Liquid Crystals and Displays, 2014, 29(5): 818-823. (in Chinese) doi: 10.3788/YJYXS20142905.0818

|

|

HALLER H L, DIRNBERGER J, GIRETZLEHNER M, et al. “Understanding burns”: research project burn case 3D—overcome the limits of existing methods in burns documentation[J]. Burns, 2009, 35(3): 311-317. doi: 10.1016/j.burns.2008.07.010

|

|

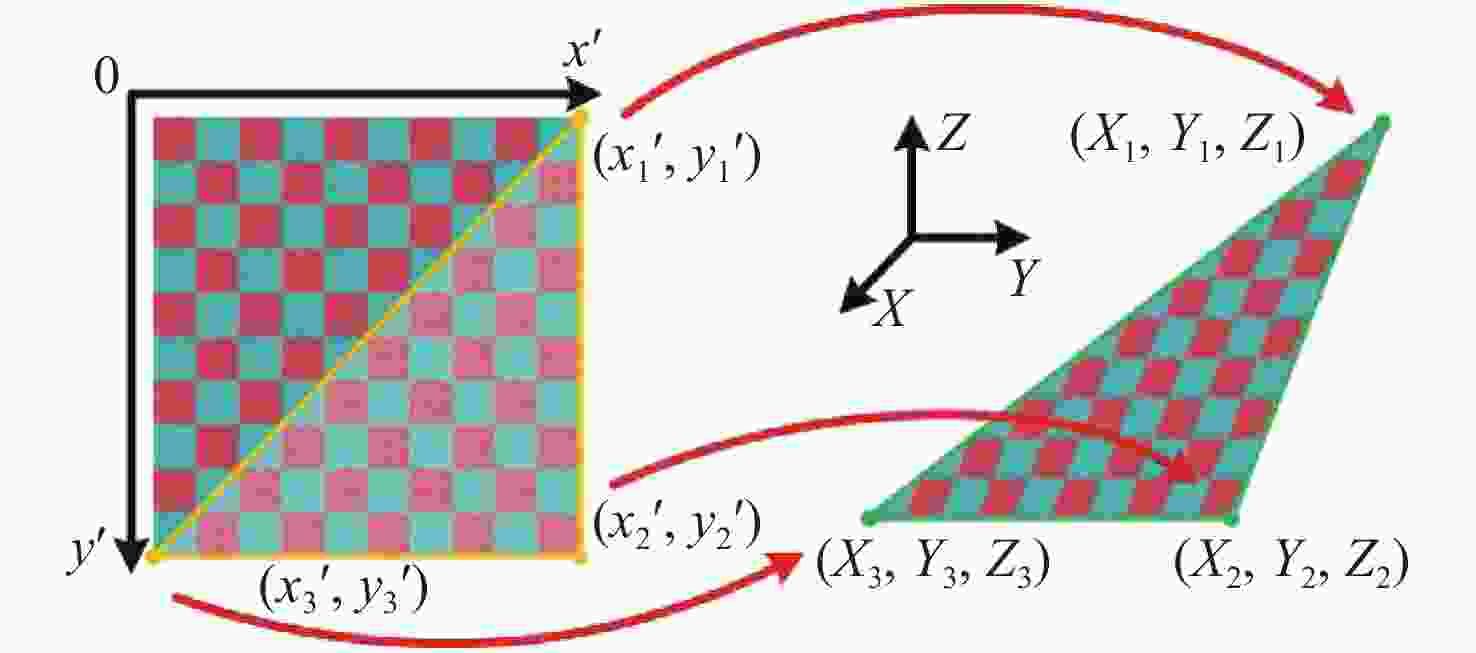

万燕, 王慧洁, 鲁俊. 基于三角网格模型的纹理映射研究[J]. 计算机应用与软件,2016,33(4):160-163, 201. doi: 10.3969/j.issn.1000-386x.2016.04.038WAN Y, WANG H J, LU J. On texture mapping based on triangular mesh model[J]. Computer Applications and Software, 2016, 33(4): 160-163, 201. (in Chinese) doi: 10.3969/j.issn.1000-386x.2016.04.038

|

|

LIU L, STAMOS I. Automatic 3D to 2D registration for the photorealistic rendering of urban scenes[C]. Proceedings of 2005 IEEE Computer Society Conference on Computer Vision & Pattern Recognition, IEEE, 2005: 137-143.

|

|

杨丽萍. 文物模型的简化与纹理映射研究[J]. 液晶与显示,2009,24(2):283-287. doi: 10.3969/j.issn.1007-2780.2009.02.025YANG L P. Simplification and texture mapping of cultural relic model[J]. Chinese Journal of Liquid Crystals and Displays, 2009, 24(2): 283-287. (in Chinese) doi: 10.3969/j.issn.1007-2780.2009.02.025

|

|

孙宇臣. 激光三维彩色数字化系统关键技术研究[D]. 天津: 天津大学, 2005.SUN Y CH. Study of key techniques of laser 3D and color digitization system[D]. Tianjin: Tianjin University, 2005. (in Chinese)

|

|

孙新领, 谭志伟, 杨观赐. 双目立体视觉在人形机器人三维重建中的应用[J]. 现代电子技术,2016,39(8):80-84, 87.SUN X L, TAN ZH W, YANG G C. Application of binocular stereo vision in 3D reconstruction of humanoid robot[J]. Modern Electronics Technique, 2016, 39(8): 80-84, 87. (in Chinese)

|

|

王晓南, 郑顺义. 基于激光扫描和高分辨率影像的文物三维重建[J]. 测绘工程,2009,18(6):53-55, 60. doi: 10.3969/j.issn.1006-7949.2009.06.015WANG X N, ZHENG SH Y. Three-dimensional reconstruction of antiques based on LIDAR and high-resolution images[J]. Engineering of Surveying and Mapping, 2009, 18(6): 53-55, 60. (in Chinese) doi: 10.3969/j.issn.1006-7949.2009.06.015

|

|

赵琳敬. 三维点云智能进化拼接与表面纹理映射方法研究[D]. 天津: 天津大学, 2018.ZHAO L J. Research on 3D point cloud intelligent evolutionary registration and surface texture mapping method[D]. Tianjin: Tianjin University, 2018. (in Chinese)

|

|

ZHANG ZH Y. A flexible new technique for camera calibration[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2000, 22(11): 1330-1334. doi: 10.1109/34.888718

|

|

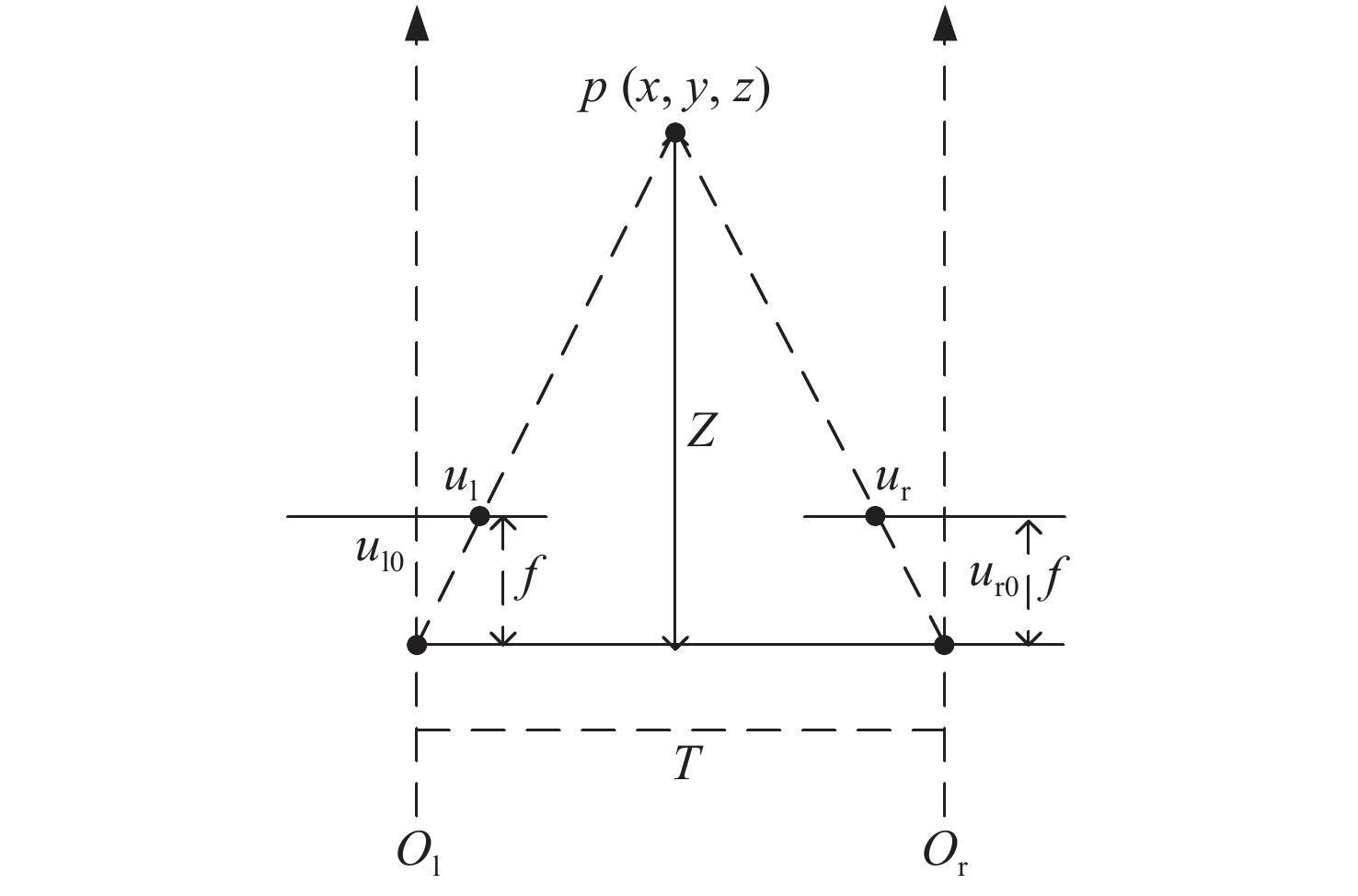

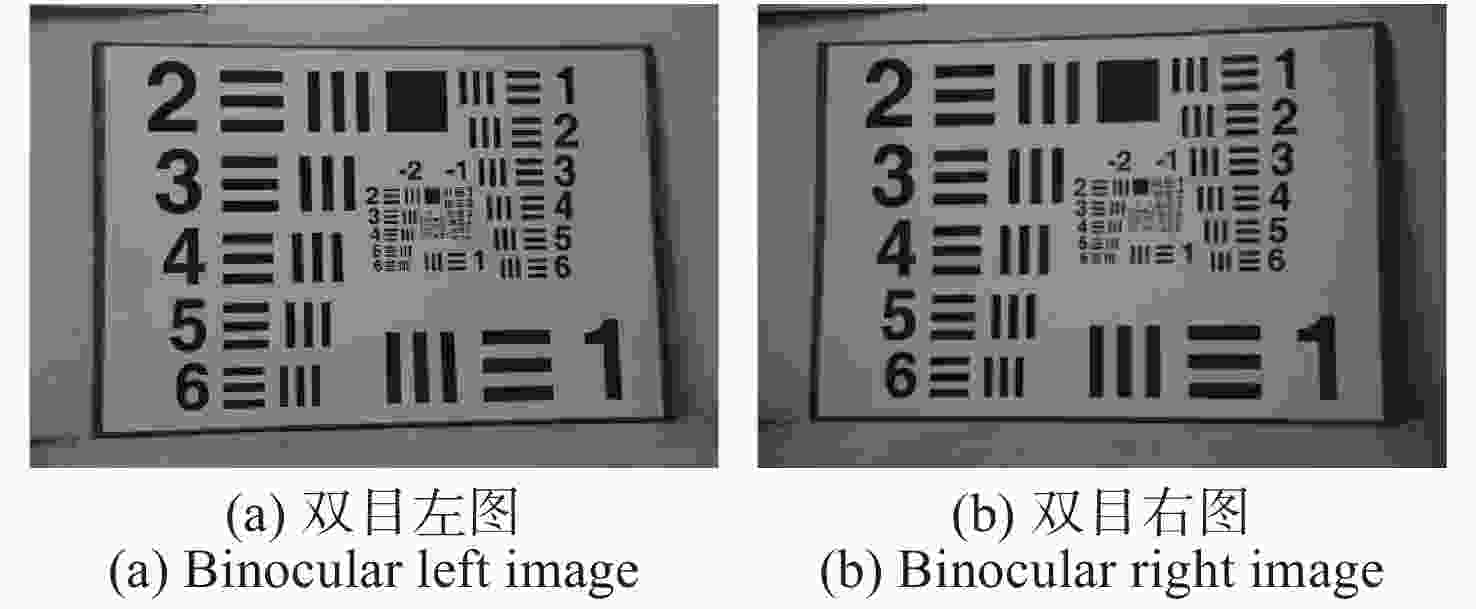

杨景豪, 刘巍, 刘阳, 等. 双目立体视觉测量系统的标定[J]. 光学精密工程,2016,24(2):300-308. doi: 10.3788/OPE.20162402.0300YANG J H, LIU W, LIU Y, et al. Calibration of binocular vision measurement system[J]. Optics and Precision Engineering, 2016, 24(2): 300-308. (in Chinese) doi: 10.3788/OPE.20162402.0300

|

|

TSAI R Y. A versatile camera calibration technique for high-accuracy 3D machine vision metrology using off-the-shelf TV cameras and lenses[J]. IEEE Journal on Robotics and Automation, 1987, 3(4): 323-344. doi: 10.1109/JRA.1987.1087109

|

|

KAEHLER A, BRADSKI G. Learning Open CV 3: Computer Vision in C++with the OpenCV Library[M]. Sebastopol: O'Reilly Media, Inc., 2016.

|

|

张来刚, 魏仲慧, 何昕, 等. 面向低纹理图像的快速立体匹配[J]. 液晶与显示,2013,28(3):450-458. doi: 10.3788/YJYXS20132803.0450ZHANG L G, WEI ZH H, HE X, et al. New stereo matching method based edge extraction[J]. Chinese Journal of Liquid Crystals and Displays, 2013, 28(3): 450-458. (in Chinese) doi: 10.3788/YJYXS20132803.0450

|

|

汪泽伟, 于有光, 杨付正. 基于HTC Vive的全景视频显示质量评估[J]. 液晶与显示,2018,33(1):85-91. doi: 10.3788/YJYXS20183301.0085WANG Z W, YU Y G, YANG F ZH. Panoramic video display quality assessment based on HTC Vive[J]. Chinese Journal of Liquid Crystals and Displays, 2018, 33(1): 85-91. (in Chinese) doi: 10.3788/YJYXS20183301.0085

|

|

ZHANG G X, ZENG ZH, ZHANG SH W, et al. SIFT matching with CNN evidences for particular object retrieval[J]. Neurocomputing, 2017, 238: 399-409. doi: 10.1016/j.neucom.2017.01.081

|

|

张昊骕, 朱晓龙, 胡新洲, 等. 基于SURF和SIFT特征的视频镜头分割算法[J]. 液晶与显示,2019,34(5):521-529. doi: 10.3788/YJYXS20193405.0521ZHANG H S, ZHU X L, HU X ZH, et al. Shot segmentation technology based on SURF features and SIFT features[J]. Chinese Journal of Liquid Crystals and Displays, 2019, 34(5): 521-529. (in Chinese) doi: 10.3788/YJYXS20193405.0521

|

|

LOWE D G. Object recognition from local scale-invariant features[C]. Proceedings of IEEE International Conference on Computer Vision, IEEE, 1999: 1150-1157.

|

|

BAY H, TUYTELAARS T, VAN GOOL L. Surf: speeded up robust features[C]. Proceedings of the European Conference on Computer Vision, Springer, 2006, 3951: 404-417.

|

|

RUBLEE E, RABAUD V, KONOLIGE K, et al.. ORB: an efficient alternative to SIFT or SURF[C]. Proceedings of 2011 International Conference on Computer Vision, IEEE, 2011: 2564-2571.

|

下载:

下载: