-

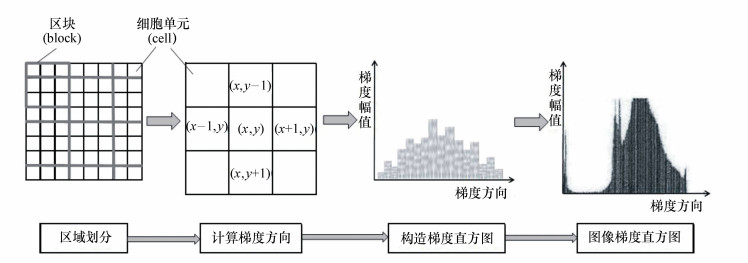

摘要: 本文针对高速环境下的车型识别问题,提出基于方向可控滤波器的改进HOG算法。将方向可控滤波器算法与HOG算法相结合,以实现对车辆图像特征提取。采用主成分分析算法(PCA)约减特征向量维数以减少计算复杂度,利用支持向量机算法对提取特征进行样本训练,实现对车辆外型特征的识别。仿真实验结果表明:采用该算法原始车辆车型的识别正确率均值达到92.36%;另外,本文方法的识别速度比传统的HOG特征算法提高了3.45%,识别实时性得到提升。本文算法比传统HOG算法更优,能有效提高车型识别的效率。Abstract: Aiming at problems of vehicle type recognition in high-speed environment, an improved HOG algorithm based on oriented steerable filter is proposed in this paper. Vehicle image features are extracted by combining the oriented steerable filter algorithm and HOG algorithm. The principle component analysis(PCA) is used to reduce dimensions of the eigenvector for decreasing the computational complexity. The support vector machine(SVM) algorithm is used to train the extracted features to realize the recognition of vehicle's appearance features. The simulation results indicate that average vehicle type recognition accurate of proposed algorithm reaches 92.36%. At the same time, the recognition speed is 3.45% higher than the traditional HOG feature algorithm. In conclusion, the proposed algorithm can effectively improve the efficiency of vehicle type recognition and is therefore better than the traditional HOG algorithm.

-

Key words:

- vehicle type recognition /

- HOG feature /

- steerable filter

-

表 1 样本训练程序参数

Table 1. Sample training program parameters

参数符号 代表属性 Num 车型图像样本数量 Type 车型图像样本类别 *x 样本遍历指针 表 2 车型识别实验结果

Table 2. Experimental results of model identification

(%) 识别算法/实验次数 1 2 3 4 5 HOG算法 83.7 85.2 85.4 85.5 84.6 本文算法 93.2 92.6 92.7 91.5 91.8 -

[1] PSYLLOS A, ANAGNOSTOPOULOS C N, KAYAFAS E. Vehicle model recognition from frontal view image measurements[J]. Computer Standards & Interfaces, 2011, 33(2):142-151. https://www.sciencedirect.com/science/article/pii/S0920548910000838 [2] WANG Y, LI H, KIRUI C K, et al. Vehicle discrimination using a combined multiple features based on vehicle face[J]. Lecture Notes in Electrical Engineering, 2013, 256:503-511. doi: 10.1007/978-3-642-38466-0 [3] LLORCA D F, COLÁS D, DAZA I G, et al. Vehicle model recognition using geometry and appearance of car emblems from rear view images[C]. IEEE, International Conference on Intelligent Transportation Systems. IEEE, 2014: 3094-3099. [4] ABADI E A J, AMIRI S A, GOHARIMANESH M, et al. Vehicle model recognition based on using image processing and wavelet analysis[J]. International Journal on Smart Sensing & Intelligent Systems, 2015, 9(2):3-8. http://s2is.org/Issues/v8/n4/papers/paper17.pdf [5] SONG M. Vehicle model recognition based on SURF[J]. Journal of Information & Computational Science, 2015, 12(17):6249-6256. http://www.researchgate.net/publication/285618863_Vehicle_Model_Recognition_Based_on_SURF [6] ZHANG X D, QIAN W, GAO J, et al. Vehicle model recognition system based on sparse bayesian classification[J]. Mini-micro Systems, 2005:232-238. http://en.cnki.com.cn/Article_en/CJFDTOTAL-XXWX200510036.htm [7] WANG Y Q, HUANG R J, XU T Y, et al. Vehicle model recognition based on fuzzy pattern recognition method[J]. Advanced Materials Research, 2012, 383-390:4799-4802. https://www.scientific.net/amr.383-390.4799.pdf [8] ZHANG Z, TAN T, HUANG K, et al. Three-dimensional deformable-model-based localization and recognition of road vehicles[J]. IEEE Transactions on Image Processing, 2012, 21(1):1-13. http://www.ncbi.nlm.nih.gov/pubmed/21724513 [9] HSIEH J W, CHEN L C, CHEN D Y. Symmetrical SURF and its applications to vehicle detection and vehicle make and model recognition[J]. IEEE Transactions on Intelligent Transportation Systems, 2014, 15(1):6-20. http://www.researchgate.net/publication/260710783_Symmetrical_SURF_and_Its_Applications_to_Vehicle_Detection_and_Vehicle_Make_and_Model_Recognition [10] CHEN Z, PEARS N, FREEMAN M, et al. A Gaussian mixturemodel and support vector machine approach to vehicle type and colour classification[J]. Iet Intelligent Transport Systems, 2014, 8(2):135-144. doi: 10.1049/iet-its.2012.0104 [11] 叶峰, 陈灿杰, 赖乙宗, 等.基于有序Hough变换的快速圆检测算法[J].光学精密工程, 2014, 22(4):1105-1111. http://www.wanfangdata.com.cn/details/detail.do?_type=perio&id=gxjmgc201404038YE F, CHEN C J, LAI Y, et al. Fast circle detection algorithm using sequenced Hough transform[J]. Opt. Precision Eng., 2014, 22(4):1105-1111.(in Chinese) http://www.wanfangdata.com.cn/details/detail.do?_type=perio&id=gxjmgc201404038 [12] 宋悦, 林志贤, 姚剑敏.基于ε-支持向量回归机的背光源亮度均匀性评价方法[J].液晶与显示, 2015, 30(5):857-863. http://www.wanfangdata.com.cn/details/detail.do?_type=perio&id=yjyxs201505019SONG Y, LIN ZH X, YAO J M. Luminance uniformity evaluation for backlight based on ε-support vector regression[J]. Chinese Journal of Liquid Crystals and Displays, 2015, 30(5):857-863.(in Chinese) http://www.wanfangdata.com.cn/details/detail.do?_type=perio&id=yjyxs201505019 [13] 李姜, 郭立红.基于改进支持向量机的目标威胁估计[J].光学精密工程, 2014, 22(5):1354-1362. https://www.cnki.com.cn/qikan-HLYZ201408005.htmlLI J, GUO L H. Target threat assessment using improved SVM[J]. Opt. Precision Eng., 2014, 22(5):1354-1362.(in Chinese) https://www.cnki.com.cn/qikan-HLYZ201408005.html [14] 王洪涛, 李丹.基于改进粒子群算法的图像边缘检测研究[J].液晶与显示, 2014, 29(5):800-804. http://www.cqvip.com/QK/97614A/201405/662543010.htmlWANG H T, LI D. Image edge detection based improved PSO algorithm[J]. Chinese Journal of Liquid Crystals and Displays, 2014, 29(5):800-804.(in Chinese) http://www.cqvip.com/QK/97614A/201405/662543010.html [15] 黄璇, 郭立红, 李姜, 等.磷虾群算法优化支持向量机的威胁估计[J].光学精密工程, 2016, 24(6):1448-1454. http://www.eope.net/gxjmgc/CN/abstract/abstract16439.shtmlHUANG X, GUO L H, LI J, et al. Threat assessment of SVM optimized by Krill Herd algorithm[J]. Opt. Precision Eng., 2016, 24(6):1448-1454.(in Chinese) http://www.eope.net/gxjmgc/CN/abstract/abstract16439.shtml [16] 贾苏娟, 韩广良, 陈小林, 等.光度非均匀彩色序列图像超分辨率重建[J].液晶与显示, 2014, 29(1):106-113. http://www.cqvip.com/QK/97614A/201401/48793439.htmlJIA S J, HAN G L, CHEN X L, et al. Super-resolution reconstruction with photometric change of color image sequence[J]. Chinese Journal of Liquid Crystals and Displays, 2014, 29(1):106-113.(in Chinese) http://www.cqvip.com/QK/97614A/201401/48793439.html [17] 徐超, 高敏, 杨锁昌, 等.视觉注意机制下的粒子窗快速目标检测[J].光学精密工程, 2015, 23(11):3227-3237. http://www.cnki.com.cn/Article/CJFDTOTAL-GXJM201511028.htmXU CH, GAO M, YANG S CH, et al. Visual attention mechanism-aided fast target detection by particle window[J]. Opt. Precision Eng., 2015, 23(11):3227-3237.(in Chinese) http://www.cnki.com.cn/Article/CJFDTOTAL-GXJM201511028.htm [18] 柯洪昌, 孙宏彬.图像序列的显著性目标区域检测方法[J].中国光学, 2015, 8(5):768-774. http://www.chineseoptics.net.cn/CN/abstract/abstract9344.shtmlKE H CH, SUN H B. A saliency target area detection method of image sequence[J]. Chinese Optics, 2015, 8(5):768-774.(in Chinese) http://www.chineseoptics.net.cn/CN/abstract/abstract9344.shtml -

下载:

下载: